Captura de pantalla de PornStarByFace / Izquierda: Lara Croft de Tomb Raider. Derecha: actriz porno Lavish Styles / Imagen: Samantha Cole

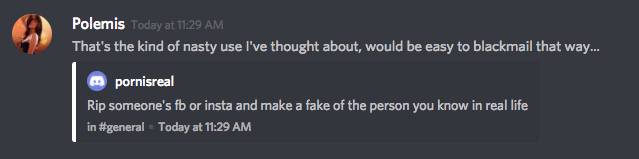

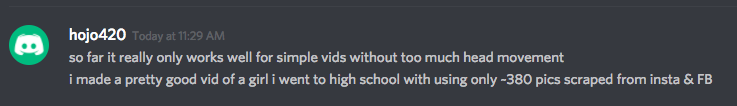

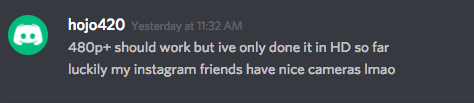

Apenas ayer, reportamos la historia de deepfakes, una comunidad creciente que crea videos porno falsos de celebridades usando material en video existente y una máquina de aprendizaje automático. Este algoritmo es capaz de tomar el rostro de una celebridad de un video público y pegarla en el cuerpo de un artista porno. A menudo, los videos que resultan son casi indistinguibles de la realidad. Se realizan mediante una aplicación gratis y amigable para los usuarios llamada FakeApp.Uno de los peores usos de esta tecnología sugerido por informáticos y éticos con quienes hablé, ya está sucediendo. La gente está hablando de usar, y en algunos casos usando activamente, esta aplicación para crear porno falso de personas que conocen en la vida real: amigos, conocidos, exes y compañeros de clase, sin su permiso.Algunos usuarios en una sala de chat en Discord llamada deepfakes, donde los seguidores intercambian tips para crear videos, afirmaron que utilizaban imágenes de gente que conocen: las compañeras con las que iban en preparatoria, por ejemplo. Un usuario dijo que hicieron un "buen video" de una excompañera de clases, utilizando alrededor de 380 fotos que sacaron de sus cuentas de Instagram y Facebook.

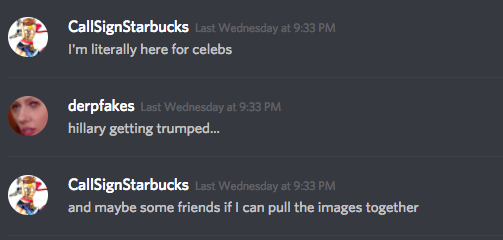

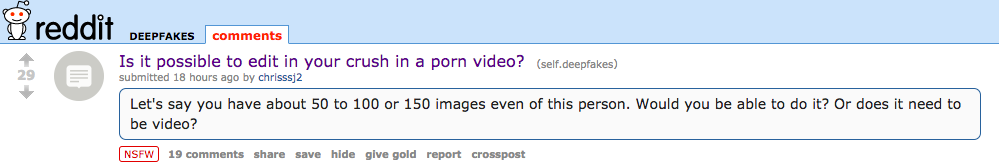

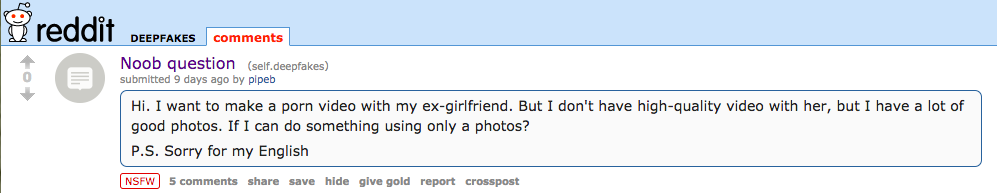

Incluso más gente en Reddit y Discord discuten sobre las posibilidades de crear videos porno falsos de sus crushes y exes, y pidiendo consejo para encontrar la mejor manera de hacerlo:

Incluso más gente en Reddit y Discord discuten sobre las posibilidades de crear videos porno falsos de sus crushes y exes, y pidiendo consejo para encontrar la mejor manera de hacerlo:

Invertí casi toda la semana pasada monitoreando estas comunidades, donde ciertas prácticas ya son comunes entre los miles de suscriptores de los grupos deepfake. Las prácticas son resultado de un comportamiento que lleva mucho tiempo en Reddit y otras comunidades en línea que no ha sido regulado en las plataformas. Esperamos que al desmitificar las comunidades que hacen esto, las víctimas del porno con IA sean capaz de entender y articular las tácticas utilizadas contra ellos; y que las plataformas en donde la gente confía sus datos personales mejoren para proteger esta información, u ofrezcan opciones de privacidad más claras para los usuarios que no las conocen.Actualización: después de publicar la historia, Discord cerró el chat donde la gente discutía la creación de videos falsos deepfake. "La pornografía no consensuada justifica un cierre inmediato de los servidores que identifiquemos, así como la expulsión permanente de usuarios", dijo un representante de Discord a Business Insider. "Hemos investigado estos servidores y los cerramos de inmediato".Las herramientas abiertas como Instagram Scraper o la extensión de Chrome DownAlbum facilitan tomar fotos de cuentas públicas de Facebook e Instagram y bajarlas en tu disco duro. Estas herramientas tienen fines legítimos. Por ejemplo, permitir que cualquiera baje una imagen publicada en la cuenta de Motherboard en Instagram y la guarde, logrando así que no desaparezca de la web. Sin embargo, los realizadores de videos Deepfake pueden utilizar estas herramientas para crear bases de datos necesarias para hacer videos porno de individuos inocentes que conocen en la vida real.

Invertí casi toda la semana pasada monitoreando estas comunidades, donde ciertas prácticas ya son comunes entre los miles de suscriptores de los grupos deepfake. Las prácticas son resultado de un comportamiento que lleva mucho tiempo en Reddit y otras comunidades en línea que no ha sido regulado en las plataformas. Esperamos que al desmitificar las comunidades que hacen esto, las víctimas del porno con IA sean capaz de entender y articular las tácticas utilizadas contra ellos; y que las plataformas en donde la gente confía sus datos personales mejoren para proteger esta información, u ofrezcan opciones de privacidad más claras para los usuarios que no las conocen.Actualización: después de publicar la historia, Discord cerró el chat donde la gente discutía la creación de videos falsos deepfake. "La pornografía no consensuada justifica un cierre inmediato de los servidores que identifiquemos, así como la expulsión permanente de usuarios", dijo un representante de Discord a Business Insider. "Hemos investigado estos servidores y los cerramos de inmediato".Las herramientas abiertas como Instagram Scraper o la extensión de Chrome DownAlbum facilitan tomar fotos de cuentas públicas de Facebook e Instagram y bajarlas en tu disco duro. Estas herramientas tienen fines legítimos. Por ejemplo, permitir que cualquiera baje una imagen publicada en la cuenta de Motherboard en Instagram y la guarde, logrando así que no desaparezca de la web. Sin embargo, los realizadores de videos Deepfake pueden utilizar estas herramientas para crear bases de datos necesarias para hacer videos porno de individuos inocentes que conocen en la vida real.

Relacionados: Con inteligencia artificial tu porno puede tener celebridades

Una vez los realizadores deepfake tienen suficientes imágenes de un rostro, necesitan encontrar el cuerpo adecuado de un artista porno. No todas las caras le quedan a cualquier cuerpo, por las diferentes dimensiones, el cabello y otras variables. Entre mejor sea la combinación de factores, más convincente será el resultado final. Esta parte del proceso deepfake también es semiautomático y está simplificado.Para encontrar el cuerpo ideal, los deepfakers usan aplicaciones de navegador que afirman utilizar el reconocimiento facial para encontrar artistas porno que se parezcan a la persona con quien quieren intercambiar rostros. Porn World Doppelganger, Porn Star By Face y FindPornFace son tres herramientas en línea fáciles de usar que dicen usar la tecnología de reconocimiento facial para encontrar un parecido porno. Ninguna de estas herramientas parece ser muy sofisticada, pero ayudan bastante a los deepfakers a encontrar la mejor estrella del porno para crear sus videos falsos. Un usuario sube una foto de la persona que quieren falsificar, el sitio encuentra a la estrella porno que podrían usar y el usuario puede buscar videos de ese artista en sitios como Pornhub para crear un video falso.En este momento, Motherboard no sabe exactamente cómo funcionan estos sitios web, más allá de afirmar que utilizan tecnología de "reconocimiento facial". Contactamos a los creadores de Porn World Doppelganger y Porn Star By Face, actualizaremos la información cuando obtengamos respuesta. Porn Star By Face dice que tiene 2,347 artistas en sus bases de datos, rescatados de los videos más populares de Pornhub y YouPorn. No sabemos si el sitio pidió permiso a estas estrellas para añadirlos a su base de datos.Un vocero de FindPornFace me dijo a través de un mensaje en Reddit que su aplicación es "casi inútil" para utilizarla con FakeApp y hacer videos, porque la aplicación no sólo busca similitud en ojos, nariz y demás, sino que necesitan una forma del rostro, mandíbula y color de piel parecidas, y así”, dijeron. “Es una tarea diferente. Pero sí, la búsqueda de algunas chicas se puede usar para crear un video falso. Es verdad".En el sitio Porn Star By Face dicen que están trabajando para mejorar el algoritmo que usan: "La red neuronal está entrenada para seguir cualquier orden que le des, por favor comparte el link con tus amigos. Trabajamos para ofrecer un alto nivel de precisión. Utilizamos varias fotos desde diferentes ángulos para crear el templete de una actriz. Después de crear el templete, probamos y corregimos los errores”.FindPornFace tiene una advertencia: “Al utilizar nuestro servicio, aceptas no subir ningún contenido que muestre a cualquier persona menor de 21 años o sin el consentimiento explícito de la persona”. El sitio Porn World Doggelganger sugiere a los usuarios que suban fotos de sí mismos, no de alguien más. Pero también ofrece varios links como opciones para encontrar gente parecida a celebridades como Selena Gomez, Nicki Minaj, Kylie Jenner y Courtney Cox.Herramientas como FindPornFace sólo automatizan parte del proceso que comunidades en Reddit, 4chan y páginas de porno de venganza como Anon-IB han estado practicando durante años: encontrando dobles del porno basándose en fotos subidas a estos sitios (y, hasta cierto punto, "cuerpos similares" para photoshoppear rostros de celebridades en artistas del porno.)Una de estas comunidades, “doppelbangher” en Reddit, tiene casi 36,000 suscriptores (otra entrada, mal escrita, “dopplebangher” tiene 11,000). Muchos, si no la mayoría, de estas publicaciones son de personas conocidas: amigos, compañeros de clase, mamás de amigos, conocidos, crushes. Los usuarios publican fotos en el subreddit (al parecer casi siempre sin permiso) y otros usuarios comentan sus mejores recomendaciones de artistas porno que se parecen. FindPornFace tiene una cuenta en Reddit que a menudo comenta sus resultados.

Relacionados: Platicamos con el director que pone a coger a tus superhéroes favoritos

Los moderadores de r/doppelbangher aconsejan en las reglas del hilo que los usuarios no deberían publicar fotos que puedan rastrearse hasta las cuentas en redes sociales si se suben a sitios como imgur. Publicar información personal, así como porno de venganza resultará la expulsión de la comunidad, escriben. "Por favor sé consciente de cómo podría sentirse si encuentran su foto aquí”.Me he encontrado a redditors que hacen peticiones con la “madrastra de un amigo”, “una compañera de trabajo”, “amigo del colegio”, “mi amiga y mi crush” y “la chica más sexy de ingeniería”, acompañada de fotos de las mujeres, tomadas directo de sus redes sociales.Si el dueño de la foto la encuentra, pueden solicitar que la eliminen. Pero con las reglas para no rastrear fotos subidas, ¿cómo va a encontrar alguien su foto sin estar buscándola directamente todos los días?Todo esto existe en una zona gris legal, como explicó Wired en su historia sobre la legalidad de los deepfakes. Las celebridades pueden demandar por el uso indebido de su imagen. El resto de nosotros tiene pocas esperanzas en el área legal. Las leyes contra el porno de venganza no incluyen lenguaje sobre imágenes falsas como poner tu cara en un cuerpo ajeno. Gran parte de la responsabilidad para prevenir esto recae en las plataformas mismas y en las políticas como estatutos contra la difamación que estén al mismo nivel de la tecnología.“Crear escenas de sexo falso de celebridades les impide conceder o negar su permiso. Está mal”, me comentó una antigua artista porno en diciembre, cuando preparamos el primer artículo al respecto. Gran parte de la actitud relacionada con los dobles y la manipulación de imagen está basada en ver a las celebridades —especialmente a las mujeres— y actores porno como mercancías, no personas "reales". Es una predisposición que surge cuando la comunidad deepfake trata a las figuras públicas en oposición a, digamos, los vecinos de al lado o los niños.Contactamos a Reddit y a los moderadores de estas comunidades, actualizaremos la información cuando obtengamos respuesta.

Publicidad

Publicidad

Relacionados: Con inteligencia artificial tu porno puede tener celebridades

Una vez los realizadores deepfake tienen suficientes imágenes de un rostro, necesitan encontrar el cuerpo adecuado de un artista porno. No todas las caras le quedan a cualquier cuerpo, por las diferentes dimensiones, el cabello y otras variables. Entre mejor sea la combinación de factores, más convincente será el resultado final. Esta parte del proceso deepfake también es semiautomático y está simplificado.

Publicidad

Publicidad

Publicidad

Relacionados: Platicamos con el director que pone a coger a tus superhéroes favoritos

Los moderadores de r/doppelbangher aconsejan en las reglas del hilo que los usuarios no deberían publicar fotos que puedan rastrearse hasta las cuentas en redes sociales si se suben a sitios como imgur. Publicar información personal, así como porno de venganza resultará la expulsión de la comunidad, escriben. "Por favor sé consciente de cómo podría sentirse si encuentran su foto aquí”.Me he encontrado a redditors que hacen peticiones con la “madrastra de un amigo”, “una compañera de trabajo”, “amigo del colegio”, “mi amiga y mi crush” y “la chica más sexy de ingeniería”, acompañada de fotos de las mujeres, tomadas directo de sus redes sociales.Si el dueño de la foto la encuentra, pueden solicitar que la eliminen. Pero con las reglas para no rastrear fotos subidas, ¿cómo va a encontrar alguien su foto sin estar buscándola directamente todos los días?Todo esto existe en una zona gris legal, como explicó Wired en su historia sobre la legalidad de los deepfakes. Las celebridades pueden demandar por el uso indebido de su imagen. El resto de nosotros tiene pocas esperanzas en el área legal. Las leyes contra el porno de venganza no incluyen lenguaje sobre imágenes falsas como poner tu cara en un cuerpo ajeno. Gran parte de la responsabilidad para prevenir esto recae en las plataformas mismas y en las políticas como estatutos contra la difamación que estén al mismo nivel de la tecnología.“Crear escenas de sexo falso de celebridades les impide conceder o negar su permiso. Está mal”, me comentó una antigua artista porno en diciembre, cuando preparamos el primer artículo al respecto. Gran parte de la actitud relacionada con los dobles y la manipulación de imagen está basada en ver a las celebridades —especialmente a las mujeres— y actores porno como mercancías, no personas "reales". Es una predisposición que surge cuando la comunidad deepfake trata a las figuras públicas en oposición a, digamos, los vecinos de al lado o los niños.Contactamos a Reddit y a los moderadores de estas comunidades, actualizaremos la información cuando obtengamos respuesta.